[Report]TRONイネーブルウェアシンポジウム36th

生成AIが切り拓く新たな障碍者支援の可能性

2023年12月2日(土)13:30〜16:30

INIADホール(東洋大学 赤羽台キャンパス)/オンライン 同時開催

- 基調講演

坂村 健:INIAD(東洋大学情報連携学部)学部長、TRONイネーブルウェア研究会会長 - 講演

千葉 慎二:日本マイクロソフト株式会社 技術統括室 エンジニア

松尾 政輝:筑波技術大学 保健科学部 情報システム学科 助教 - パネルセッション

千葉 慎二、松尾 政輝、高村 明良:全国高等学校長協会 入試点訳事業部 理事、坂村 健(コーディネータ)

AI(人工知能)の進化により、音声認識システムや視覚支援アプリケーション、そしてロボット技術などが大きな発展を遂げている。その応用により、障碍者の日常生活や職場でのサポートを強化する技術が実用化され、障碍者に新たな活動の機会が提供されている。

本シンポジウムでは、それらの技術の事例を紹介する。特に、視覚障碍者向けのリアルタイム環境認識アシスト技術に焦点を当て、これらの技術がどのように障碍者の自立を促進し、社会参加を支援するかについて議論していく。

パネルセッションでは、AI技術が就労支援を含むさまざまな障碍者支援において果たす役割や可能性について、その将来を展望する。

基調講演

生成AIが切り拓く新たな障碍者支援の可能性

坂村 健

生成AIの可能性を広げたLLM

生成AIはあらゆることに使えるため、すべての人が社会を支えられるような世界が現実的になってきた。日本では少子高齢化が進み、働き手が減っていく中で、障碍者の自立と社会参加の促進が課題になっているが、生成AIを活用すれば、むしろ障碍者は未開拓の人材プールと考えることができ、その社会参加が進めば、働き手不足の解消につなげることができる。坂村教授はこう講演をスタートさせた。

生成AIのもとになっているのは大規模言語モデル(LLM:Large Language Model)。LLMは大量の学習をもとに連想によって一連の言語要素の次に何が来るかという次単語の予測しかできないとみなされていたが、実際には翻訳、要約、分類、抽出、感情分析など、さまざまな目的で使えることがわかってきた。坂村教授はヨハネの福音書から「はじめに言葉ありき、言葉は神なればなり」という一節を引用し、人間の脳がニューラルネットワークで実現している「言葉」による抽象化能力こそが汎用AIの鍵だったのではないか、と説いた。

LLMがText2Everythingを実現

現在、LLMをベースにして言葉を理解することで、さまざまなクリエイティブを行うAIが誕生している。たとえば、Text2Voice(発話)、Text2Text(作話や翻訳)、Text2Image(作画)、Text23D(モデリング)、Text2Video(動画)、Text2Music(作曲)、Text2Motion(振り付け)、Text2Code(プログラミング)、さらにはText2Action(ロボットの行動決定)など、これらは総称して「Text2Everything」とよばれている。LLMが多様な応用の基礎になっており、まさにLLMは「ファウンデーション・モデル」と位置づけられている。

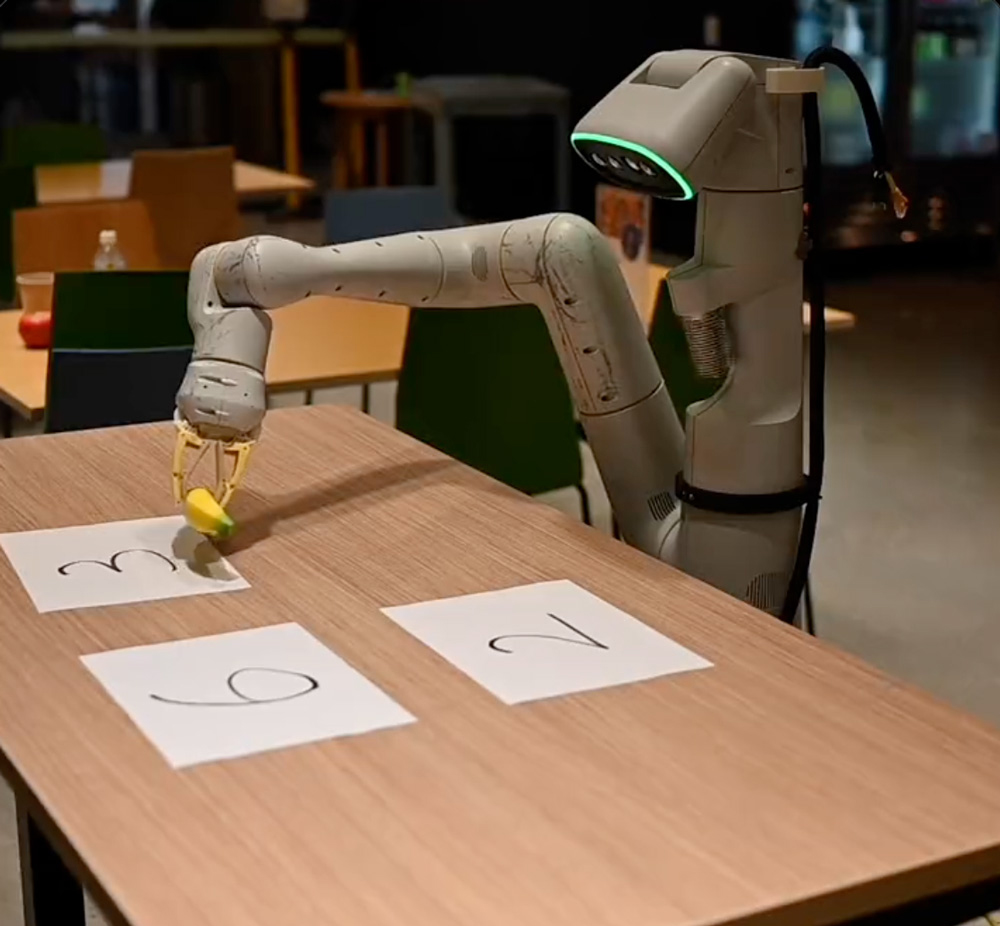

ここで坂村教授は、視覚と言語を行動に翻訳する言語モデルVLA(Vision-Language-Action)の例として、Googleが2022年8月に発表したRT-1(Robotic Transformer 1)を紹介。「コーヒーこぼしたから、拭くもの持ってきて」というような曖昧な自然言語による指示に対して、自律的に判断してスポンジを選ぶような「賢さ」を実現している。さらに2023年7月に発表された最新のVLAモデルRT-2(Robotic Transformer 2)は創発能力と汎化性能が向上し、「テーブルから落ちそうなバッグを拾う」、「バナナを2+1の和の数字の上に移動させる」など、ロボットが以前に見たことのない環境に対してのパフォーマンスを、RT-1の32%から62%に向上させたという。注目すべきは、これらの実現のために特別に単語の意味や数字の概念などを事前に学習させたのではなく、汎用的な言語モデルからのみ達成しているということだ。

https://www.youtube.com/watch?v=E2g1APtSuUM

https://twitter.com/i/status/1684903412834447360

生成AIで可能になる障碍者支援

坂村教授は、こうした汎化性能を持ったLLMベースのVLAモデルは、人間的な配慮や忖度もできる介助ロボットに応用できるとし、生成AIによる障碍者支援の可能性の例をあげた。

○ 生成AIによるコミュニケーション支援の可能性

- 視覚障碍者向けの説明的テキスト生成:画像や動画の内容を説明するテキスト生成

- 聴覚障碍者向けのリアルタイム音声翻訳:音声からテキストや手話への即時翻訳

- リアルタイム発話支援:発話障碍の個性を学習して聞き取りやすい合成音声で発話

○ 生成AIによるクリエイティブ支援の可能性

- 読み取り支援:文字の音声化やさらには要約により、視覚障碍、失読症、運動障碍などのある人が長い文章を読むことを容易に

- 作文支援:短い入力を補うことで、視覚障碍、失読症、運動障碍など文字入力に時間のかかる人が、文章やプログラムなどを書くことを容易に

- 作曲・作画などクリエイティブ一般の支援:AIでテキスト化すれば、そこから生成させ簡単な指示で選択・調整して各種クリエイティブも可能に

○ 生成AIによる情報的支援の可能性

- アクセシブルなデジタルコンテンツの生成:さまざまな障碍を持つ人々のためのアクセスしやすいデジタルコンテンツへの変換・生成

- 個別化された教育資料の作成:学習障碍を持つ人々向けにカスタマイズされた教材や学習プログラムを生成

- 高度な会話型アシスタントの開発:リマインドやルーチンの確立などで記憶障碍や発達障碍者を日常生活で支える会話型AIアシスタント

- 感情認識と適切な応答:ユーザの感情を認識し安定化やモチベーション維持のために適切に応答するAIシステム

○ 生成AIによる物理的支援の可能性

- 介助ロボット:障碍者の日常生活のタスクを支援するための物理的なアシストロボット

- スマートホーム自動化:障碍者が生活しやすいようにIoTを活用した家庭内のデバイスの自動化

- 自動運転車両・車いす:視覚障碍者や身体障碍者が独立して移動できるようにする自動運転技術

- ナビゲーションと活動支援:通路、道、物品配置、扉等の周辺状況を画像認識し、IoTやマップ情報などと統合判断して、視覚障碍者や身体障碍者の移動や活動を助けるガイドソリューション

生成AIにより支援のパーソナル化が可能に

INIADでは2023年よりINIAD AI-MOP(AI Management and Operation Platform)を導入し、全学生が有料モデルのGPT-4とGPT-3.5-turboのAPIを利用できるようにした。するとさっそくINIADの学生が障碍者を支援するためのアプリを作成した。視覚障碍者向けの状況説明アプリは、スマートフォンで画像認識し、周囲の状況や案内看板の内容を音声で具体的に説明したり、目標物までの距離を音声や音で案内したりできる。また、LLMを用いた聴覚障碍者向けの音声要約筆記ツールは、会話の途中に挟まれる「えー」や「あの」といった音声はカットした状態で書き起こしを作成できる。

従来はさまざまな障碍に対して個別に対応するのは現実的ではないと言われていたが、このように生成AIによって障碍者支援アプリの開発も容易になったことで支援のパーソナル化──個人の状態や要望に対して多様なソリューションをマッチングさせて、最良の支援パッケージを設計して提供することが可能になったのである。

障碍者の社会進出へつなげるために

障碍者に社会進出してもらうといっても、障碍者の雇用面での課題を解決する必要がある。特に懸念されているのは、採用選考時にAIスクリーニングツールを用いることによって、過去に起こったような障碍者差別を増幅、加速、自動化してしまうのではないかということだ。坂村教授は「今こそAIを何に使うべきか、そして何に使うべきではないかを明確にしておく必要がある」と主張した。

一方、米国の先進的なIT企業では、ニューロダイバーシティ採用が導入されている。ニューロダイバーシティとは、自閉スペクトラム症やADHD、統合運動障碍などを能力の欠如や優劣ではなく、人間の多様性の一つとして捉え、相互に尊重し社会のなかで活かそうとする考え方である。つまり、それらの障碍者には優れた集中力や分析的思考能力があり、環境さえ整えればIT開発などに力を発揮すると考えられるようになっているのだ。坂村教授はAIによって雇用面での課題解決に取り組んでいる企業の一例として以下を紹介した。

- Microsoft:ニューロダイバーシティ採用プログラム、アクセシビリティのためのAI助成金プログラム

- Mentra:ニューロダイバーシティコミュニティの包括的な採用プラットフォーム

- Zammo.ai:障碍を持つあらゆる人が音声を使って簡単に求人情報を発見し、応募できるようにするソリューション提供

- LinkedIn:求人プラットフォームのアクセシブル化、雇用者向けの障碍者雇用のための学習コースの開設

そして「日本ではこうした取り組みを大々的に打ち出している企業は少ないが、ぜひ多くの企業に取り組んでいただきたい」と基調講演を締めくくった。

講演

さまざまな困難を克服する支援技術とAIの可能性

千葉 慎二

日本マイクロソフト株式会社 技術統括室 エンジニア

日本マイクロソフト株式会社の千葉慎二氏は、Mixed Reality(MR:複合現実)といった最先端技術の活用と、困難を抱えた人や支援が必要な人のアクセシビリティに関する仕事に携わっている。

マイクロソフトといえばWindowsやOfficeなどのイメージが強いが、同社の企業理念は、障がいの有無や年齢などに関係なく、さまざまな人がテクノロジーの力で恩恵を受けられる社会を目指すことにある。WindowsやOffice製品の中にもさまざまな感覚支援に関するテクノロジーが搭載されているが、それは最近の話ではなくてWindows95の時代から引き継がれ、進化し続けているものである。千葉氏は感覚支援の例を大きく視覚支援、聴覚支援、身体支援(モビリティ)、発達支援(ニューロダイバシティ)の四つに分類し、その中からWindows11に実装されたライブキャプション機能を紹介した。これは聴覚支援機能の一つで、YouTubeの映像を再生すると音声認識によって自動的に字幕を表示することができる。また、Windowsの機能を音声で操作することができる音声アクセス機能は昔から実装されている支援の一つだが、こうした機能もAIの技術によって洗練されたものが搭載されている。

こうしたAIの技術は、マイクロソフトのクラウドサービスAzure上で動作する認知AI「Cognitive Services」で網羅されている。Cognitive Servicesは、人間の認知(Cognitive)を模した機能を、Web APIとしてすぐに利用できる「AIパーツ」である。AIやデータサイエンスの技術知識を使わずに、視覚、音声、言語、決定、検索といった認知ソリューションを構築できる。Cognitive Servicesをベースとしたさまざまな機能がOSやアプリケーションにも導入されている。

マイクロソフトが無料で提供する視覚障がい者向けスマートフォン用アプリ「Seeing AI」は、カメラに映った印刷文字を読み上げたり、周りの風景や人の様子を文字化して音声で説明したりする機能を持つ

iPhone用とAndroid用があり、18言語83地域に対応している。こうした機能は生成AIによって自然で違和感のない読み上げが可能になるなど、より進化していく可能性がある。

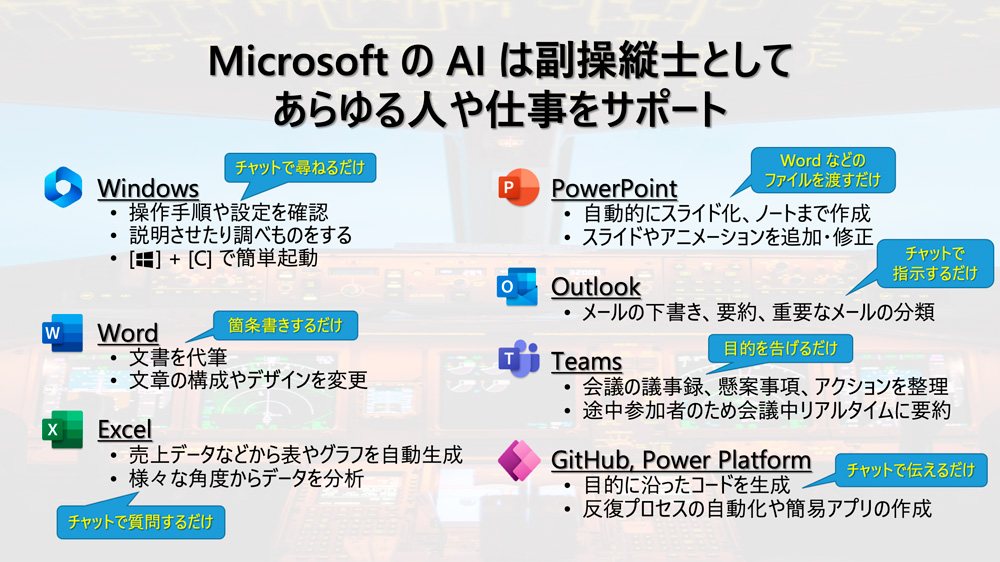

続いて千葉氏は、生成AIの活用事例としてWindowsに搭載されている「Copilotコパイロット」機能を紹介。副操縦士を意味するAI「Copilot」がメインパイロットであるユーザを支援して生産性向上をサポートするというものだ。具体的には、Windowsの操作やOffice製品による資料作りがより簡単かつ便利になるよう支援する。たとえば視覚障がい者向けの「ダークモード」設定を有効にする場合、設定画面を開かなくてもチャットや音声で切り替えることができるので、設定にたどり着くまでの時間や労力が大幅に減少した。また、Wordの要約機能や箇条書き機能は、障がい者だけでなく健常者にとっても便利な機能である。

さらに生成AIの特徴をうまく活用するための事例として、点字ディスプレイに出力することで盲ろう者に災害時に必要な情報(避難経路)を伝える「AI & 点字ソリューション」を紹介。そして、生成AIによる読み上げ順序の最適化の研究や、発達障がいや認知症などでコミュニケーションが難しい人向けに個人の経験や属性から言いたいことやりたいことをサポートする生成AIの研究などを紹介した。

最後に千葉氏は「マイクロソフトはさまざまなAIを単体ではなくいろいろ組み合わせて使うことによって、さまざまな障がいをお持ちの方や高齢の方を支援するという研究を続けて、製品にも反映していきます」と締めくくった。

生成AIによる視覚障害者支援の現状と今後への期待

~活用事例とその応用を通して~

松尾 政輝

筑波技術大学 保健科学部 情報システム学科 助教

筑波技術大学の保健科学部情報システム学科で助教を務める松尾政輝氏は、視覚や聴覚に障害がある学生を対象にプログラミングを教えたり、障害の有無によらず楽しめるゲームの研究や視覚障害者の歩行移動に関する支援アプリの開発などを当事者と一緒に行ったりしている。本講演では全盲の視覚障害当事者の視点から、生成AIによる視覚障害者支援の現状と期待について語った。

日本国内で身体障害者手帳を所持していて視覚障害と認定されている人は約31万2,000人、手帳を所持していない人を含めると160万人、世界では2億8,000万人ほどいるといわれている。視覚障害の種類としては大きく、視覚以外の感覚により生活し教育を受けている全盲と、視覚障害はあるが残っている視覚情報も活用しながら生活や教育を受けているロービジョン(弱視)に分類される。こうした障害者は、白杖、点字、単眼鏡、ルーペなど、「見えない」ことや「見えづらい」ことを支援するための機器や工夫のもとで日常生活を送っている。視覚障害者がコンピュータを利用する際は、全盲の人であれば画面の内容を音声で読み上げるスクリーンリーダー機能によってマウスは使わずにキーボードで操作する。ロービジョンの人は画面を拡大したり色彩を変更したりして自分の見やすい環境を作って使っている。

ICTを使って視覚障害者の生活を支援するためのさまざまな技術開発も進んでいる。以前は専用の福祉機器を使うのが一般的であったが、アクセシビリティ機能を持ったスマートフォンが普及したことにより、一般的なハードウェアを活用した障害者支援の動きが活発になってきた。たとえば歩行支援には、GPS情報、コンパス情報、カメラ映像、距離センサーなどを活用して、位置情報、空間情報、経路を音声や振動パターンで伝達できる。また、文字情報に対しては、スキャナやカメラで活字文書を撮り、レイアウトを解析して文書を音声で読み上げることができる。

松尾氏は生成AIの活用事例として、OpenAIのChatGPTによる視覚障害者支援について紹介した。筑波技術大学でも、授業の中でChatGPTを使って、課題を解決し、理解し、支援することが行われている。画像や広告が多用されるウェブブラウザの画面ではスクリーンリーダーを使うと状況を把握しづらいため、プロンプトでテキストベースの対話ができるChatGPTのほうが自分に適した情報をより早く正確に入手できるという一面がある。ChatGPTによる英文の添削や文章の誤字脱字の修正などは、障害の有無にかかわらず利用できる便利な活用法だ。

また画像生成AIについて松尾氏は、AIとのテキストベースの対話により、必要な図表・イラストを作成できる可能性に触れた。作成した画像が目的の内容になっているかを確認したり、修正点があれば対話を繰り返して画像を修正したり、画像情報をテキストで説明してもらったりすることにより、目的とする結果を障害者自身が得られるようになる。

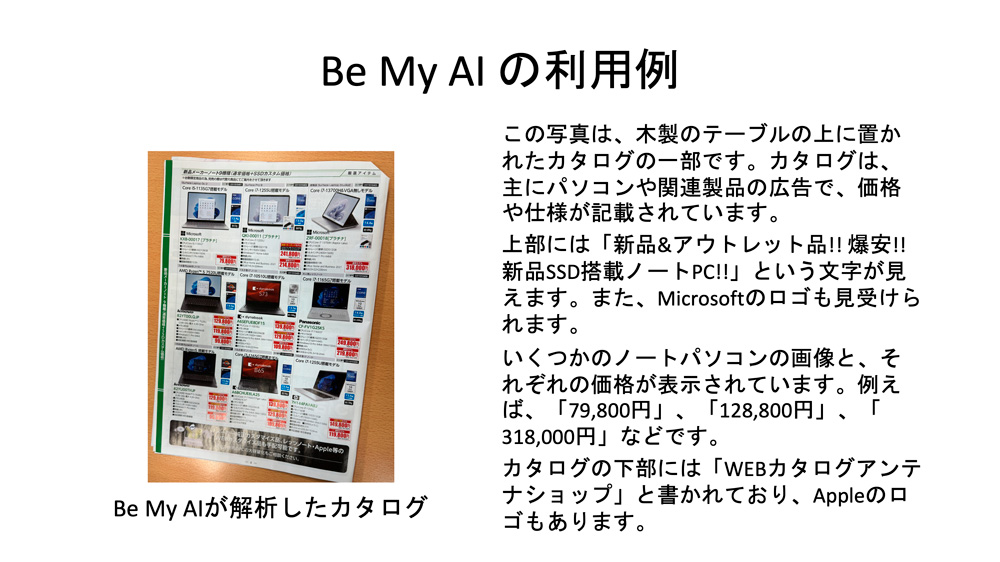

「Be My Eyes」は2015年にデンマークで誕生したiPhoneアプリで、スマートフォンからの動画映像をボランティアにつなぎ通話により支援を受けるという、ボランティアベースの視覚支援サービスである。全世界で50万人の視覚障害者(2023年5月)、ボランティア600万人(2022年10月)が登録しており、歩行支援、モノ探し、機器の操作支援などに活用されてきた。この「Be My Eyes」に最近追加された「Be My AI」は、人間のボランティアの代わりにOpenAIのGPT-4モデルを利用したバーチャルボランティアが視覚支援を行う。ユーザが撮影した写真をAIが解析し、風景(空間情報)や、活字情報(レイアウトと文字情報)などをAIが解説する。テキストベースでAIと対話することで画像内のより詳細な情報を取得したり、バーチャルボランティアで解決できないことは人間のボランティアに通話を引き継いだりもできる。製品カタログのような複雑なレイアウトでも自然に解析して情報を伝えてくれるサービスはこれまでになかったという。

松尾氏は、質問の内容によっては晴眼者には一目瞭然の情報でも、現時点ではAIでは正確に伝えられない場合もあり、その情報が正しくないことを視覚障害者のユーザが知る方法がないという課題を指摘した。今後のAI技術の発展により徐々に解決できることもあるだろう。

さらに、カメラのライブ映像を用いて動画情報を解析して読み上げる「Envision AI」、「Eye Navi」、「BlindSquare」、「EnVision App/Glasses」といったアプリやウェアラブル端末を紹介した。いずれも生成AIを導入することにより、視覚障害者の歩行移動支援ツールとしてさらなる機能強化が期待されるものばかりである。

最後に松尾氏は、視覚障害者支援における生成AIのさらなる活用について、生成AIの活用により映像情報やドキュメントのチェックなど、視覚補助の幅が広がりつつあることをあげ、視覚障害者支援のために開発される生成AIは、健常者にとっては行動の幅を広げるための機能としても応用できるので、ゆくゆくはすべての人々の暮らしを豊かにできる可能性を秘めていると展望を語った。

パネルセッション

登壇者

千葉 慎二、松尾 政輝、高村 明良(全国高等学校長協会 入試点訳事業部 理事)

コーディネータ

坂村 健

パネルセッションには全国高等学校長協会入試点訳事業部で理事を務める高村明良氏も登壇し、コーディネータの坂村教授の進行で闊達な意見が交わされた。

高村氏は坂村教授がイネーブルウェア研究会を立ち上げた初期のころから親交があり、東京大学の坂村研究室によく足を運んでいたという。研究会では、視覚障碍者への支援として、文字処理のための支援と移動支援をテーマにさまざまな研究が行われていた。30数年前を振り返ると、当時のスクリーンリーダーは機能が不完全なものだったが、坂村教授は「将来的にはスクリーンリーダーは野球中継をするようにテレビ画面の内容をきちんと読み上げてくれるようになるだろう」と予見しており、「夢物語だと思っていたが、ついにそういう時代がやってきた」と感慨深そうに語った。移動支援に関しても、坂村教授が「将来は靴を履くと靴が振動して情報を教えてくれるようになるだろう」と話していたことを紹介したが、そうした歩行支援の研究も実際に行われているという。

高村氏は、「生成AIが使われることによって、単なる画像解析だけでなく、レイアウト解析などより深い部分まで解析して、その結果を対話型で説明してくれるのが大きな変化。今後、我々がコンピュータを使っていくうえで、何をしたいかをきちんとコンピュータに伝えることによって、より速いアクセスが可能になってくるのではないか」とした。そして、「これから我々が何を思い描きながらこれらを使い発展させていくのかが、イネーブルウェア研究会の次の大きな課題になるだろう」と展望を述べた。

松尾氏は、生成AIを活用すれば就労の幅が広がるという発想に衝撃を受けたといい、「生成AIによって周りの環境が個々に合わせて対応することで、その人にとってパフォーマンスを発揮しやすい環境を作れるのであれば、さまざまな障害があっても、また障害がなくても、いろいろな立場の人にとって生成AIはすばらしいものになる」と感想を述べた。

千葉氏は高村氏の話を受けて、「坂村先生が今日話していたことは、20年後、30年後に実現するのではないか」と語る一方で、現在視覚障碍者に使われているものにも課題があることをあらためて認識したといい、「そうしたバリアを下げていくことで20年後、30年後に今よりも皆が生活しやすい、すばらしい世の中になっていく」と期待を込めた。

生成AI

以降は、参加者からの質問に登壇者が回答するかたちで進行した。

生成AIに関して「AIも人間のように母語が必要なのか」「日本語ベースの生成AIの開発はされているのか」といった質問に対して、坂村教授は「生成AIでは、英語や日本語といった母語を意識する必要はない」と回答。ニューラル言語モデルにおけるべき乗則(Scaling Laws:性能が計算量のべき乗に比例する関係)の発見によって、パラメータ数を増やして大量に学習させればさせるほど賢くなることが、すでにわかっているし、今のところその上限もないという。英語主体で学習しただけなのに簡単な英語とフランス語の翻訳ができたという例をあげ、マルチリンガルの環境で育った子どもが母語を意識しないように、AIのLLMでは言語を特定せずに、プログラム言語なども含めてあらゆる言語を学習したほうが賢くなる。すでにLLMは将棋や囲碁の棋譜も学習に使われているぐらいなので、手話や点字を学習させることも可能だし、映画「2001年宇宙の旅」にHAL 9000が読唇術を使っていたシーンも現実的になってきたと述べた。千葉氏も「AIの賢さに関して母語は本質ではない」としたうえで、日本語の細かい表現やニュアンスがAIに求められるのであれば、それを学習する必要はある、と受けた。

次に「音声ガイダンスに呼吸音が聞こえた」という質問について、千葉氏は「人間が話すときには呼吸をしてから声を出し、それが自然な会話につながっていく。最近の音声合成は、呼吸を含めたノイズみたいなものも重ねて自然な発話に近づけている」と説明した。何年か後には、人とAIの区別もつかなくなるし、違いも気にならなくなるだろうとのことだ。

逆に、人の声と区別できるように音声合成に不自然さを残す必要はあるのだろうか。千葉氏は「使い道による」と回答。ネット上で会話そのものを楽しむのであれば、相手が人でもAIでも不自然さを感じないほうがよいが、ディープフェイクに使われるなど悪用されるのは問題なので、日々進化していく技術をどう倫理観を持って使うのかということだろう。

「日本語の音声を文字変換する場合、同音異義語、地名や人名は生成AIにとっても難しいのか」という質問に千葉氏は「やはり難しい」と回答。たとえば「河野」という苗字は「コウノ」とも「カワノ」とも読めるが、今のところ、特定の状況でどちらが正しい呼び方なのかをパラメータとして外部から入力しておくことが必要だという。将来的には「この会議に参加している人はこういった方々なので“河野”の読み方はこうだ」と、AIが自動的に判断して、そこから合成していく言葉を選んでいくかたちになるだろうと指摘した。

視覚障碍者の日常と支援のあり方

話題は視覚障碍者に関しての質問に移った。

「視覚が不⾃由な状況では⼆次元的なGUI(Graphical User Interface:マウスや画⾯タッチで指⽰を与える)でコンピュータを操作するのが難しい。そこで、コンピュータの基本に立ち返り一次元情報である点字やモールス信号でコンピュータを操作するしくみがほしい」という意⾒に対し、松尾⽒は、一次元情報を使った操作はCUI(Character User Interface:タイピングして指⽰を与える)を使うことに相当するとしたうえで、「現在はGUIベースの操作が主流だが、⽣成AIが普及することで視覚が不自由な人は言葉を使って操作することが可能になるだろう」と回答。松尾⽒によると、⼀次元的に操作するのか⼆次元の平⾯を頭の中で思い描いて操作するのかは、その⼈の視覚の経験や、それまでのパソコンの操作経験によって変わってくるそうだ。また、スマートフォンはアクセシビリティが充実しているので、逆に指で画⾯に触れただけでは操作を決定できないが、アプリのインタフェースを覚えてしまえば画⾯上のものを⾃由に操作し、⼆次元上の情報をたどって必要な情報を探せるようになるのだという。

続いて「視覚障碍者の歩行支援の研究は、生成AIとスマートフォンの連携が主流なのか。生成AIと白杖の連携の研究事例はあるのか」という質問。高村氏は、生成AIと連携させた支援は、スマートフォン、白杖、靴などいろいろなアイデアが考えられるが、現状のスマートフォンや生成AIを使った移動支援は、歩行者がそれに気を取られて周囲の認知がおろそかになりがちなことを指摘。解決方法の一つは、人間側が両方の情報を同時に受け取る訓練をすることだが、それは人間がコンピュータの状況に合わせていることになる。「将来的にはコンピュータ側が我々の状況を判断して、必要な情報だけを提供できるようになれば、本当の移動支援といえる」と、コンピュータと人間の関係を逆転しないと、本当の支援にならないと主張した。

「生成AIによって義足や義手の技術の発展は期待できるか」という質問に対して、坂村教授はBMI(ブレイン・マシン・インタフェース)の研究が生成AIによって進展していることを例にあげ「発展は期待できる」と断言した。また、「発達障碍者はコミュニケーションの問題で職場になじめず、職場を転々としてしまうことがあるが、そうした課題も生成AIの発展によって解決できるのか」という発達障碍者の就労支援における生成AIの可能性に関しての質問があった。それに対して坂村教授は、リマインドやルーチンの確立など、発達障碍者の日常生活を支える高度な会話型アシスタントの研究開発が進んでいて、さらに、ユーザの感情を生成AIが認識することで、感情を安定させ、モチベーションを維持するために適切に応答する研究もあり期待できると応じた。千葉氏も「文脈を読み取って把握するのか、さらに支援まで行うのか。入力と出力のどちらにも使えるのが生成AI。一つの使い方だけではなく、マルチモーダルでさまざまな入力と出力を組み合わせていくことが必要」と語った。

坂村教授は「今の生成AIの進化のスピードを考えると、自分が今日話したことが実現するのに20~30年もかからないだろう。生成AIはあらゆるものに影響を与えるが、私のような研究者もいらなくなるのではないか」という。なぜなら、昔は自分の専門分野だけを研究していればよかったが、今はあらゆる分野の知識を使わないと最先端の研究ができないからだ。どれだけ真面目に勉強していても人間には限界があり、生成AIの勉強のスピードには太刀打ちできないのだ。千葉氏は同意しつつも「逆に研究者がAIを新しい知識として使っていく、武器として役立てるという使い方がある」と提案すると、坂村教授は、「人間には生きるための欲望があるが、今のところAIには「何のために」という欲望がない。人間の研究者の意思でドライブしてAIを目的達成の道具として使うのが、ベストかもしれない」と応じた。

障碍者へのAI支援の課題と展望

「障碍者をAIで支援するためには、多様な障碍者のデータの集積が必要なのではないか」という意見には坂村教授も同意。「TEPSでは長年障碍者がどういうことに困っているのか、我々は何をすべきなのかということをテーマにしてきたので、その議事録をAIに入れて学習させるべき」と主張すると、高村氏は「生成AIはたくさんのデータを集めたうえで、そこから一番確からしいものを取り出せることが能力の一つ。さまざまな障碍に関する情報の中からどのように共通点を導き出して、コンピュータが個人に合わせていくことができるのかが重要になる」と受けた。さらに、学習したことがフェイクニュースや差別につながらないよう人が軌道修正するファインチューニングの重要性を説いた。

障碍者をAIで支援することの課題について、千葉氏は「支援される側を置き去りにしないこと。支援する側の想定で始めてあとから調整するのではなく、最初から支援される側のことを考えて始めるという発想が大事」とし、松尾氏は「AIが誤った支援をした場合に、それをそのままにせず、当事者自身が協力して自分がどういう支援を受けたいのかをフィードバックして修正していくことが重要」と加えた。高村氏は、生成AIアプリの使い方として「スマートフォンで子どもの写真を撮って、今子どもが何をしているのかを音声で説明してもらったり、電車の中で空席を探したり並んでいる列の状況を確認したりすることがあるが、スマートフォンを人のほうに向けることで不快な思いをさせたり人間関係を損ねたりする懸念がある」と指摘。マイクやカメラを搭載したスマートフォンがデバイスとして便利なので広く使われているが、過渡期の今は周囲の理解を得られないこともある。機能向上とあわせて啓蒙も必要なのだろう。

坂村教授は「生成AIの問題解決のスピードは速いので、障碍者自身も支援する側の人も、いろいろな立場の人が生成AIにデータを入れたり、社会に発信したり、自分の頭で考えてどんどん意見を言っていくことが大事」と説いた。さらに「障碍者や高齢者の支援や介護をする人も大変なので、支えている側の人たちに役に立つものも必要」という意見に、松尾氏は「Be My Eyesのように支援者を固定せずインターネットを通した多数の支援者による柔軟な運用ができれば、支えている側の負担が減らせる。AIが間違ったことをしても人が対応できる」と応じた。

高村氏は、障碍者に限らず、誰もが年を重ねれば視力が弱くなったり体力が衰えたりしていくことに触れ、「生成AIによる支援システムは、いろいろな人がいろいろな状況で使えるので、障碍者への理解に加えて生成AIによる支援システムへの理解を深めておくことで、将来的に自分にも役立つものだということを広く知ってもらいたい」と呼びかけた。「支援システムは障碍者のためだけではなく、一生を生きていくための一つのシステム」というメッセージは象徴的だ。

「日本にはAIツールを使いこなせる人が少ないことが問題だ」という意見に対し、坂村教授は「日本人は新しいものを使うのを恐れる傾向があって、現状を変えたくない人が多い。勉強をしない人ほど拒否反応が強くなる。AIと一緒に生きていくというのは、障碍者とAIというだけではなく、すべての人間とAIの関係に言えること」とした。これからは誰もがAIに向き合わざるを得ない時代になるのだろう。

高村氏は、過去のTEPSで駅のホームドアの設置について議論したエピソードを紹介した。高村氏は当時、視覚障碍者の立場でホームの安全性について強く主張したというが、今はほとんどの駅にホームドアが設置されており、それは視覚障碍者だけでなく多く人に役立っている。「生成AIによる支援システムもそうあってほしい」と期待を込めて語った。

* * *

会場の参加者だけでなくオンラインでの視聴者からも多くの質問や意見が届き、話題の尽きないパネルセッションとなった。

坂村教授は最後に、AIをはじめとしたソフトウェアの進化だけでなく、エッジデバイスやハードウェアの改善も両輪で進めていくことの重要性を訴えた。そして、すべての参加者へ感謝の意を表してセッションを締めくくった。

編集部注) 登壇者の発表内容に基づき「障碍」「障害」「障がい」を使い分けています。